ニューラルネットワークに基づく時系列予測手法まとめ: LSTNet, RNN, LSTM, GRU

LSTNetの論文*1を読む機会があったので、関連手法であるニューラルネットワークをベースとした時系列予測の手法についてまとめました。本記事では、RNNをはじめとして、その派生であるLSTM、GRU、LSTNetについて紹介していきます。

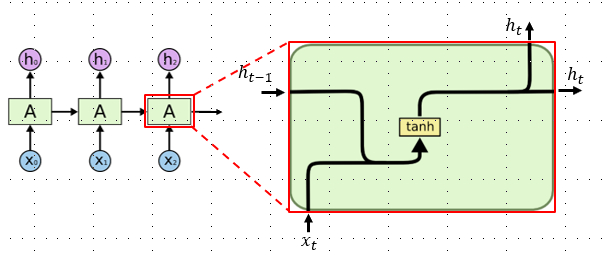

RNN (Recurrent Neural Network)

RNN(Recurrent Neural Network) とは、ある層の出力を別の層の入力として利用するような再帰的構造を持ったニューラルネットワークです。

RNNの各時刻における中間出力は隠れ状態と呼ばれ、これは当該時刻tの時系列情報と前時刻t-1の隠れ状態

を組み合わせて活性化したものです。

tanh(ハイパボリックタンジェント)を使った活性化は下式のように表すことができます。

RNNのメリットは、独立した各時点での情報だけでなく前後の時系列情報を活用することができることです。一方で、RNNにはデメリットもあります。

RNNのデメリットは、直前の中間出力のみを使うため長期の時系列情報をうまく学習することができない点にあります。

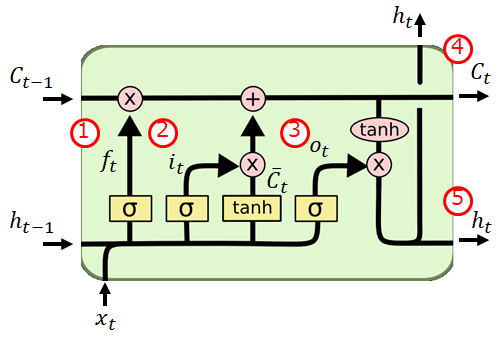

LSTM (Long Short-Term Memory)

LSTMとは、RNNのデメリットであった長期の時系列情報を考慮することで長期的な依存関係の学習を可能にしたRNNの派生モデルです。

LSTMのメリットは長期間記憶を保持することで長期的な依存関係を考慮して回帰を実現できる点にあります。

LSTMの中間出力はRNNでも中間情報として出力されていた隠れ状態とLSTM特有のセル状態の2種類があります。

また、LSTMの特徴として忘却ゲート、入力ゲート、出力ゲートの3種類のゲートを持つという点があります。ゲートとは、情報をどの程度つぎの時刻に伝達するかを制御するコンポーネントであり、0から1の値をとります。

① 忘却ゲート

② 入力ゲート

③ 出力ゲート

④ セル状態出力

⑤ 隠れ状態出力

GRU (Gated Recurrent Unit)

GRUとは、LSTMの忘却ゲートと入力ゲートを単一の更新ゲートにマージし隠れ状態のみを伝達していくニューラルネットワークのモデルです。

GRUのメリットは、LSTMと比べて学習パラメータが少ないためより短い時間で学習することができるという点にあります。

① リセットゲート

② 更新ゲート

③ 活性化層

④ 隠れ層出力

LSTNet

LSTNetは、ニューラルネットワークベースの多変量時系列予測モデルです。

LSTNetは大きく以下の3つのコンポーネントで構成されています。

① 特徴抽出を行うConvolution層

② 過去の短期・長期の時系列情報を伝達しながら伝達するRecurrent層

③ Recurrent層出力を結合しARモデルの出力と統合する層

Convolution層

Convolution層では入力された多次元時系列データに対し、畳み込みフィルタを複数適用させることで短期間の特徴および変数間の関係について抽出するように学習します。

Convolution層の出力は各フィルタを

とすると下式で表すことができます。

Recurrent層

Recurrent層は一般的なRecurrent Layer(GRU)と他Layerの2-Layer構造になっています。Layerの組み合わせは以下の通りです。

① Recurrent Layer(GRU) + Recurrent-Skip Layer

② Recurrent Layer(GRU) + Temporal Attention Layer

Recurrent-LayerはGRUモデルとなっており、 Convolution層の出力を入力としています。活性化関数は一般的なGRUモデルとは異なり、tanhではなくRELUを採用しています。

Recurrent-Layerの出力は以下の式で表すことができます。

Recurrent-Skip LayerはRecurrent-Layerと同様に、 Convolution層の出力を入力としたGRUモデルが採用されています。 あらかじめ周期がわかっているデータについては、p個周期ごとの隠れ状態のみを使った予測を行うことができます。pを明示的に定め、p個分スキップすることで重要な情報を失うことなく伝達することができます。電力消費のデータであれば、24時間周期になるようにpを設定するといった使い方をします。

Recurrent Skip-Layerの出力は以下の式で表すことができます。

Recurrent Layer(GRU) + Recurrent-Skip Layerの全結合後の出力は次のように表すことができます。

これは時刻tのRecurrent-Layerの出力と、p-1時刻前までのRecurrent Skip-Layerの出力の和を表しています。

Temporal Attention LayerではRecurrent Skip-Layerとは異なりpを明示的に決めることはせず、Attention Layerを用いて過去系列の隠れ表現の注目度を算出し、予測に使用する過去系列の重みを決定して予測を行います。データに既知の周期性がない場合や、周期が動的変化する場合に有効です。

Recurrent Layerで出力した隠れ表現系列を とすると、Attentionベクトル

は各時点の隠れ表現とt-1時刻の隠れ表現との間の類似度を求めたものであり以下のように表すことができます。

重み付きの隠れ表現ベクトルをとすると、Recurrent Layer(GRU) + Temporal Attention Layerの出力は以下のように表現することができます。

全結合+ARモデル層

LSTNetの最終出力は (Recurrent Layerの全結合) と

(ARモデルの出力)の和となります。ARモデルの出力結果と合わせることで、スケール変化の大きいデータに対してよりロバストな予測を実現することができるとされており、これは論文内の評価セクションにて説明されています。

まとめ

ニューラルネットワークベースの時系列予測手法であるRNN, LSTM, GRU、LSTNetの4手法についてご紹介しました。特に次元が大きい多次元時系列データに対しては一般的な回帰モデルよりも高い精度が期待できるため、このあたりの手法はおさえておきたいですね。

*1:Modeling Long- and Short-Term Temporal Patterns with Deep Neural Network, https://arxiv.org/pdf/1703.07015.pdf